PROYECTOS FINALIZADOS

PROYECTO src-HALS

Sistema robotizado colaborativo para cirugía laparoscópica asistida por la mano

Entidad financiadora: Ministerio de Ciencia e innovación. CICYT

Referencia: DPI2013-47196-C3-1-R

Universidad: Universidad de Málaga, Universidad Miguel Hernández, Universidad de Valladolid

Duración: Desde 01/01/2014 hasta 31/12/2016

Investigador Responsable: Víctor Fernando Muñoz Martínez

Habilidades

Group | Ability | Level | Description |

Configurability | Mechatronic Configuration | 2 | User Run-time configuration. The configuration, both in terms of software operating parameters and mechatronic configuration can be altered by the user during the cycle of operation. |

Adaptability | Parameters | 2 | Individual Parameter adaptation. The system alters individual parameters in any part of the system based on assessments of performance local to the module on which the parameter operates. |

Components | 2 | Adaptation of individual components. The system selects one of several processing components based on online feedback during operation. | |

Task | 2 | Single task adaptation. A single task performed during the process cycle is adapted over time to optimise a particular metric. This adaptation is achieved by strategic overview of the performance of the system while carrying out the task. Adaptation is the result of accumulated experience. | |

Interaction | Human-Robot | 5 | Task sequence control. The system is able to execute sub-tasks autonomously. On completion of the sub-task user interaction is required to select the next sub-task resulting in a sequence of actions that make up a completed task. |

Human-Robot Feedback | 2 | Augmented haptic feedback. The system feedbacks visual information about the state of the operating environment around the robot based on data captured locally at the robot. The user must interpret this visual imagery to assess the state of the robot or its environment. | |

Robot-Robot | 1 | Communication of own status. Two or more robots communicate basic status information and task specific status. Status information is pre-defined for the task. The information communicated only relates to the state of the robot within the task. | |

Human-Robot Safety | 1 | Basic Safety. The robot operates with a basic level of safety appropriate to the task. Maintaining safe operation may depend on the operator being able to stop operation or continuously enable the operating cycle. The maintenance of this level of safety does not depend on software. | |

Dependability | Dependability | 2 | Fails Safe. The robot design is such that there are fail safe mechanisms built into the system that will halt the operation of the robot and place it into a safe mode when failures are detected. This includes any failures caused by in-field updates. Dependability is reduced to the ability to fail safely in a proportion of failure modes. Fail safe dependability relies on being able to detect failure. |

Motion | Unconstrained | 4 | Position constrained path motion. The robot can execute a path motion where the path is constrained by physical objects or by defined zones that must be avoided. The robot is able to execute a path to an unvisited location obeying constraints. |

Constrained | 1 | Compliant motion. The robot can execute motions that change in response to external forces applied to the robot such that the force exerted on the external body is controlled. The robot is able to maintain position and path in the absence of any external force. The force is working on the robot only at the intended tool tip, and the environment is static and rigid. | |

Manipulation | Grasping | 1 | Simple pick and place. The robot is able to grasp any object at a known pre-defined location using a single predefined grasp action. The robot is then able to move or orient the object and finally un-grasp it. The robot may also use its Motion Ability to move the object in a particular pattern or to a particular location. Grasping uses open-loop control. |

Holding | 1 | Simple holding of known object. The robot retains the object as long as no external perturbation of the object occurs. | |

Handling | 1 | Simple release. The robot is able to release an object at a known pre-defined location, but the resulting orientation of the object is unknown. The object should not be prematurely released. | |

Cognitive | Action | 3 | Sense driven action. The robot is able to modulate its action in proportion to parameters derived from its perceptions. The perceptions are used to drive the selection of pre-defined actions or the parameters of pre-defined actions. |

Envisioning | 2 | Dynamic motion prediction. The robot is able to project the effect of its motion to predict short term interactions with both static and dynamic objects in the environment that the system can detect. | |

Human Interaction | 2 | Task context interaction. The system is able to interpret commands from the user that utilise task context semantics within a domain specific communication framework appropriate to the range of the task. The system is able to relay task status to the user using task context semantics suitable for the task. |

Resumen

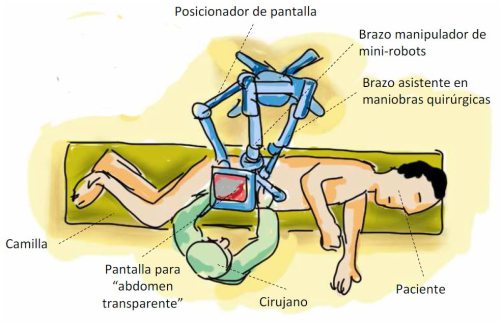

La cirugía asistida con la mano (HALS) representa un nuevo escenario intermedio entre la cirugía laparoscópica clásica y la laparotomía (ver Figura 1). En ella, el cirujano introduce una mano en el abdomen para manipular los órganos, mientras que con la otra utiliza el instrumental convencional de la cirugía mínimamente invasiva. Este tipo de abordaje resulta útil en situaciones complejas, donde no se puede aplicar la cirugía laparoscópica clásica, y se ha demostrado que los tiempos de recuperación del paciente no resultan superiores a esta última técnica.

La presente propuesta pretende abordar el desarrollo de un sistema robotizado orientado al abordaje HALS y encuadrado dentro del concepto de robot “co-worker”, donde la máquina trabaja codo con codo con el cirujano, colaborando en las maniobras quirúrgicas y aprendiendo de la práctica. Se persigue el objetivo de que con la experiencia mejore la asistencia que realiza y que sea capaz de detectar situaciones de emergencia. Para ello, se plantea que este sistema robotizado comprenda un manipulador capaz de operar una herramienta laparoscópica articulada y un endoscopio, y otro especializado en el movimiento de mini-robots dentro de la cavidad abdominal. Por otro lado, incluirá una interfaz persona-máquina fundamentada en un guante quirúrgico inteligente y la capacidad de emular el concepto de “abdomen transparente” mediante la combinación de imagen real con realidad aumentada. Así, se espera que el sistema reconozca la fase actual de la intervención mediante el uso de los gestos de la mano del cirujano, el movimiento que realiza con el instrumento laparoscópico o a través de las lecturas de las señales fisiológicas combinadas con un modelo paciente-intervención. Con esta información, los brazos robóticos actuarán de forma colaborativa con el cirujano y le asistirán con la herramienta articulada y ubicando el endoscopio y los mini-robots en las localizaciones adecuadas para proporcionar una visión completa y adecuada del campo quirúrgico. Asimismo, el sistema de “abdomen transparente” visionará la información de interés para el cirujano. Todo ello, se articulará a través de una arquitectura cognitiva que incorporará un sistema de supervisión que velará por la integridad del sistema, el desarrollo de la intervención y la seguridad del paciente.

Así, en este proyecto se abordarán técnicas y metodologías para la realización de movimientos colaborativos con instrumental laparoscópico que contemplen tanto el control de posición como de fuerzas para asistir en maniobras de anudado, clipado y cauterización, entre otras. En segundo lugar, se abordará el problema de la detección de gestos quirúrgicos HALS, que junto con la integración con información de las señales fisiológicas, ayudará a identificar la fase actual de la intervención. Además, como tercer componente se desarrollarán métodos para emular el concepto de “abdomen transparente” mediante el uso de modelos virtuales personalizados del paciente, el uso de un sistema de visión consistente en un endoscopio y mini-robots cámaras y la información proveniente del guante quirúrgico inteligente. Finalmente, se trabajará en instanciar una arquitectura cognitiva que albergue todos estos desarrollos y que verifique el concepto de robot “co-worker”. Como conclusión, para verificar todo el trabajo realizado se prevé la realización de una serie de experimentos in-vitro.

Solución Global

En la Figura 1 se presenta una posible configuración del sistema robotizado colaborativo para cirugía laparoscópica asistida por la mano que se pretende desarrollar. Este sistema realizará las labores de asistir al cirujano emulando su mano no diestra, proporcionar una interfaz basada en el concepto de “abdomen transparente”, y de realizar un seguimiento del paciente a través de sus señales fisiológicas a lo largo de toda la intervención. Para ello, el asistente robótico estará dotado de un primer brazo manipulador que operará un instrumental quirúrgico articulado habitual en la cirugía mínimamente invasiva, y que responderá con movimientos automatizados para asistir en maniobras donde se requieren las dos manos, como el anudado de vasos sanguíneos o la sutura. Un segundo brazo manipulador se encargará de mover por la cara interior del abdomen una serie de mini-robots cámara a través de un agarre magnético exterior.

Figura 1

Así, el sistema robótico gracias a un entrenamiento previo conocerá el protocolo de la intervención, los gestos que realiza el cirujano con la mano y el instrumental y un modelo paciente-intervención obtenido por las respuestas de sus señales fisiológicas. Por otro lado, la mano que el cirujano introduce en el interior del paciente estará enfundada en un guante quirúrgico inteligente dotado de sensores tanto para localizar la punta de los dedos como de otros microdispositivos como sondas ecográficas. Estos dos elementos le conferirán al sistema robótico la capacidad de conocer tanto la fase actual de la intervención como la maniobra quirúrgica en ejecución para decidir cómo tiene que asistir al cirujano. Esta se completará con información virtual, en forma de realidad aumentada, para la que se utilizará un modelo computerizado del paciente y los datos provenientes de los micro-dispositivos del guante quirúrgico inteligente. Con ello, se persigue el dar una visión global del campo operatorio tal y como si se tratase de cirugía abierta.

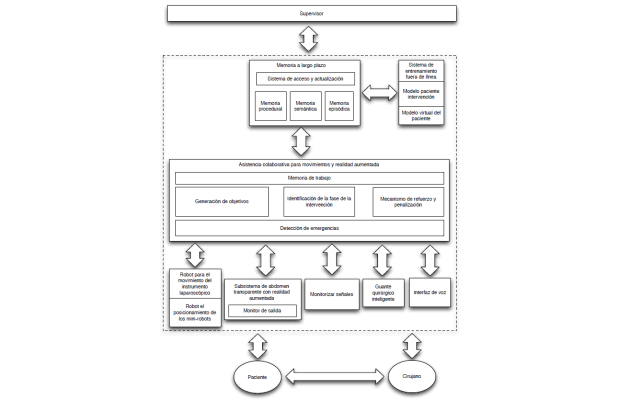

Mediante un enfoque cognitivo, el sistema robótico podrá aprender a asistir con mayor eficiencia al cirujano y podrá aprender a identificar situaciones de emergencia o no previstas. Para ello, se utilizará un paradigma de arquitectura cognitiva basado en el esquema de la Figura 2. En concreto, el núcleo del sistema lo representa el módulo denominado “Asistencia colaborativa para movimientos y realidad aumentada”, el cual se encarga de generar el próximo objetivo a cumplir teniendo en cuenta la fase del protocolo de la intervención en ejecución y los mecanismos de refuerzo y penalización establecidos según la experiencias previas de colaboración. Para ello, utiliza la información almacenada en la memoria a largo plazo, compuesta de procedural, semántica y episódica, la cual ha sido inicializada con los modelos paciente-intervención y virtual, así como con las maniobras quirúrgicas consideradas. La detección de emergencias ocupa un lugar destacado, ya que se encargará de establecer cuando se produce una situación de este tipo, y por tanto, incidirá en el cambio del plan de seguimiento del protocolo quirúrgico.

Figura 2

Objetivos planteados y logros alcanzados

1. Desarrollo de estrategias de colaboración con el cirujano en la ejecución de maniobras quirúrgicas basado en el uso de un guante quirúrgico inteligente

Este objetivo consiste en la consecución de un sistema plenamente colaborativo con el cirujano en función de la fase de la intervención en la que se encuentre en cada momento. Para ello, se utilizará la fusión de la información proveniente del guante quirúrgico inteligente y de otras fuentes de datos del quirófano. De este modo, se incidirá en técnicas que permitan modificar el comportamiento del sistema a partir de la experiencia.

2. Diseño y desarrollo de un sistema con realidad aumentada que incluya el concepto de abdomen transparente

Se abordará el diseño de un sistema completo de abdomen transparente que sea capaz de usar datos particulares del paciente a intervenir (ya sean datos obtenidos en fase preoperatoria como intraoperatoria). Dicho sistema deberá ser a su vez generalizable a un sistema de realidad aumentada de forma que se pueda mostrar información basada en modelos matemáticos de puntos de vista no directamente accesibles con la cámara.

3. Diseño y desarrollo de un sistema de detección y resolución de situaciones de emergencia

Se considerará en el marco de este objetivo el desarrollo de un sistema que sea capaz de prever, en función de las señales fisiológicas convenientemente recogidas y tratadas en fusión con la información obtenida de las imágenes laparoscópicas o ecográficas, la posible ocurrencia de situaciones de emergencia comunes que puedan suceder en las intervenciones a asistir.

4. Integración y evaluación de la eficiencia del sistema completo mediante la ejecución de una serie de experimentos in-vitro

Este objetivo consiste en la integración de todas las tecnologías desarrolladas en una serie de demostraciones. Deesta forma, se realizará un estudio documentado que establezca cómo el uso del sistema desarrollado presenta ventajas con respecto a la cirugía convencional así como los problemas e inconvenientes que aparezcan.

LOGROS

Definición de arquitectura cognitiva y diseño de experimentos

- Establecimiento de un escenario genérico de intervención HALS con el objeto de identificar las prestaciones que debe incorporar el robot colaborativo.

- Identificación y diseño de todos los componentes de la arquitectura, así como las comunicaciones entre ellos, siguiendo el modelo SOAR de arquitectura cognitiva, el cual es el que se adecua más a sus requerimientos.

- Establecimiento de tres escenarios de pruebas y la métrica que se utilizará para la realización de las pruebas de funcionamiento con el sistema robótico:

- Concepto de abdomen transparente

- Identificación de gestos del cirujano y movimientos colaborativos.

- Detección de situaciones de emergencia mediante bioseñales e imagen intraoperatoria.

Establecimiento de la memoria a largo plazo

Universidad de Málaga:

- Desarrollo de un escenario para el uso colaborativo de un robot mini-cámara dentro de un escenario de gestos y movimientos colaborativos.

- Set-up in-vitro con el objetivo de que un robot mini-cámara proporcione el punto de vista adecuado en cada instante de una intervención ficticia compuesta por un conjunto de maniobras.

- Aprendizaje en línea para situar el robot mini-cámara de forma más adecuada para un cirujano en particular y según la maniobra que realiza.

Con ello, se estableció una codificación para la memoria procedural, otra para la semántica y para la episódica. Se completó con el establecimiento de una regla de aprendizaje que modifica el comportamiento del sistema para adaptarse más a los requerimientos del cirujano. Finalmente, se realizó la integración en la arquitectura de control y se llevó a cabo una serie de experimento in-vitro para validar los trabajos desarrollados.

Planificador híbrido de movimientos y fuerzas de interacción para herramientas robotizadas

Universidad de Málaga:

- Motorización de un instrumento quirúrgico de laparoscopia estándar para poder actuar tanto la pinza como la orientación de la misma.

- Primitivas de movimiento del brazo robótico que porta el instrumento para que este último pivote sobre el punto de entrada en el abdomen y permita la interacción con tejidos internos. La estrategia de control se ha fundamentado en un esquema de control híbrido de fuerza-posición que utiliza un sensor de fuerzas situado entre la muñeca del robot y el instrumento motorizado.

- Aprendizaje por demostración para movimientos más complejos del instrumental, en colaboración con un grupo de la ESA (Agencia Espacial Europea).

Generación de un modelo virtual personalizado del paciente

Universidad Miguel Hernández:

- Modelo virtual basado en el simulador de un proyecto anterior (DPI2010-21126-C03-2), que incluye la dinámica de fluidos para la simulación de sangrados.

- Incorporación de los mini-robots cámara e iluminación.

- Construcción de un set-up físico para experimentación con los robots quirúrgicos. Este set-up incorpora órganos deformables, tubos flexibles con un líquido pulsante y pequeñas electrónicas que simulan las señales de un paciente real. Este simulador físico está siendo modelado como simulador virtual, de forma que se pueda verificar el correcto funcionamiento del simulador virtual.

Supervisión del campo operatorio y detección de situaciones de emergencia

Universidad Miguel Hernández y Universidad de Valladolid:

- Algoritmo para la detección de situaciones de sangrado en tiempo real, basado en las imágenes de video endoscopio.

- Algoritmo basado en el procesamiento de imagen endoscópica para la detección detección de vendas para garantizar que se retiran todas al finalizar la operación.

Realidad aumentada para simular abdomen transparente

Universidad de Málaga:

- Puesta en marcha de un sistema de visión intraoperatoria compuesto por mini-robots cámara y otros tantos mini-robots iluminación. Nuevo diseño de mini-robots cámara caracterizados por poder orientar con dos grados de libertad el objetivo y así cubrir más campo intraoperatorio sin la necesidad de desplazar todo el mini-robot.

- Agarre magnético que, desde el exterior, los fija al interior de la pared abdominal.

- Sistema de actuación basado en cables para controlarlos desde el exterior de la cavidad abdominal.

- Experimentos in-vivo para probar la adecuación del diseño de los mini-robots durante una intervención para la extracción de un riñón.

- Puesta en marcha de un sistema de visión intraoperatoria compuesto por mini-robots cámara y otros tantos mini-robots iluminación. Nuevo diseño de mini-robots cámara caracterizados por poder orientar con dos grados de libertad el objetivo y así cubrir más campo intraoperatorio sin la necesidad de desplazar todo el mini-robot.

Universidad Miguel Hernández

- Desarrollo de la electrónica de unos biopatchs para la comunicación NFC inalámbrica.

- Trabajos preliminares con las librerías de realidad virtual para el desarrollo de un sistema que permita integrar la información de las cámaras en el modelo virtual.

Localización de la posición y orientación de los dedos del cirujano

Universidad de Valladolid:

- Obtención en tiempo real de la posición y orientación en el espacio de los dedos de la mano del cirujano dentro del abdomen del paciente a través de dos mecanismos:

- Parámetros proporcionados por el guante sensorizado, que provee información sobre el grado de flexión entre cada una de las falanges y metacarpianos de la mano.

- Par estereoscópico proporcionado por dos microcámaras, que proporciona la posición en el espacio de las falanges distales (punta de los dedos) en tiempo real.

- Obtención en tiempo real de la posición y orientación en el espacio de los dedos de la mano del cirujano dentro del abdomen del paciente a través de dos mecanismos:

- Generación un volumen aproximado de la mano del cirujano dentro de la cavidad abdominal para evitar posibles colisiones de la mano del cirujano con los mini-robots colaborativos. Dicho volumen varía según la posición que adopte la mano.

Integración y cotrol de sensores quiúrgicos para desarrollar el guante

Universidad de Valladolid:

- Integración en el guante de un sensor de presión para que el cirujano recupere, en parte, el tacto que pierde por la presión ejercida en el brazo del cirujano por el puerto único en cirugía HALS.

- Estudio de la integración de un sensor de temperatura utilizando el mismo sistema que para el sensor de presión que determinaría la temperatura límite en una cauterización, evitando así efectos secundarios no deseados como la estenosis, y permitiría la obtención directa de la temperatura de los tejidos y órganos.

Detección de eventos por la evolución de variables fisiológicas

Universidad de Valladolid:

- Identificación de escenarios quirúrgicos (anastomosis intestinal, extirpación del bazo) para realizar un modelado preciso de las tareas quirúrgicas y determinar qué variables fisiológicas deben vigilarse, en qué márgenes de variación y qué relaciones existen entre ellas. Dicho modelo se elaborará a partir la evolución de los parámetros fisiológicos representativos, cuyos valores se obtendrán tanto del equipamiento del quirófano como de los sensores incorporados al guante.

- Comienzo de integración de estos modelos con la información proporcionada por el subsistema de detección automática de sangrado, de tal forma que se puedan identificar determinados eventos a partir de la evolución de las variables fisiológicas implicadas.